е смотря на название, сегодняшняя статья продолжение эпика Собираем грабли при обновлении VMware vSphere 5.5 до vSphere 6.0.

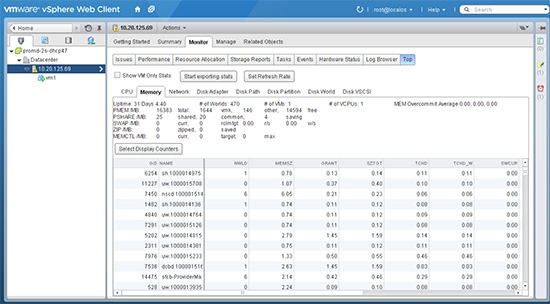

Для затравки, первый баг на сегодня очень радует — желтый баннер с текстом «Quick stats on hostname is not up-to-date». Судя по vCenter Server 5.5 and 6.0 displays a yellow warning in the Summary tab of hosts and reports the error: Quick stats on hostname is not up-to-date (2061008), разработчики синхронизируют фиксы с серьёзным лагом.

А теперь к основному блюду.

Как неправильно обновлять хост ESXi 6.0 с Cisco Nexus 1000V

После обновления супервизора VSM Cisco Nexus 1000V пришло время обновлять карты расширения VEM.

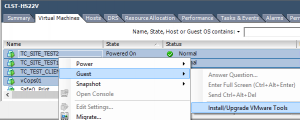

При попытке обновления Update Manager ругнулся на VIB cisco-vem-v173-esx , который я снёс командой

vem stop

esxcli software vib remove -n cisco-vem-v173-esx

а сам хост удалил из коммутатора Remove from VDS.

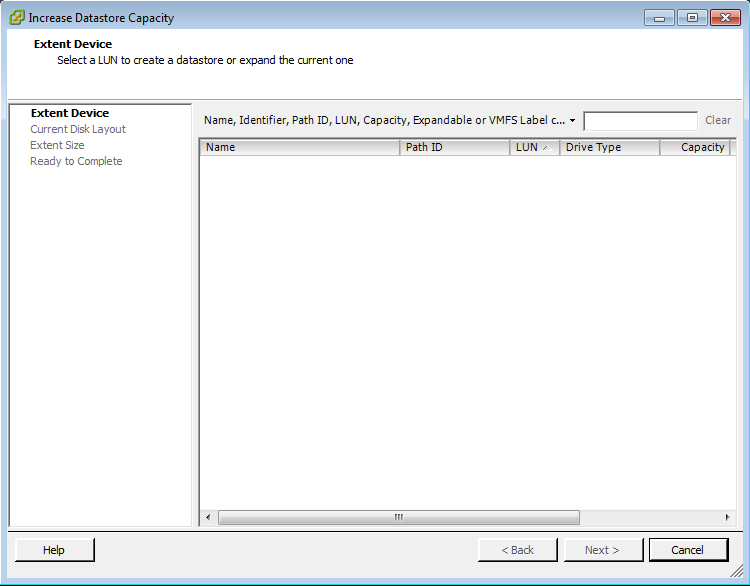

Это было жёсткой ошибкой, так как после обновления возможности добавить хосты c ESXi версии 6.0 на данный момент нет — хосты просто не отображаются в списке выбора.

Я понадеялся на только что вышедшую версию Cisco Virtual Switch Update Manager Release 1.3, но браузер зависает при обращении из vSphere Web Client, так как, похоже, продукт до сих пор не поддеживает vCenter 6.0.

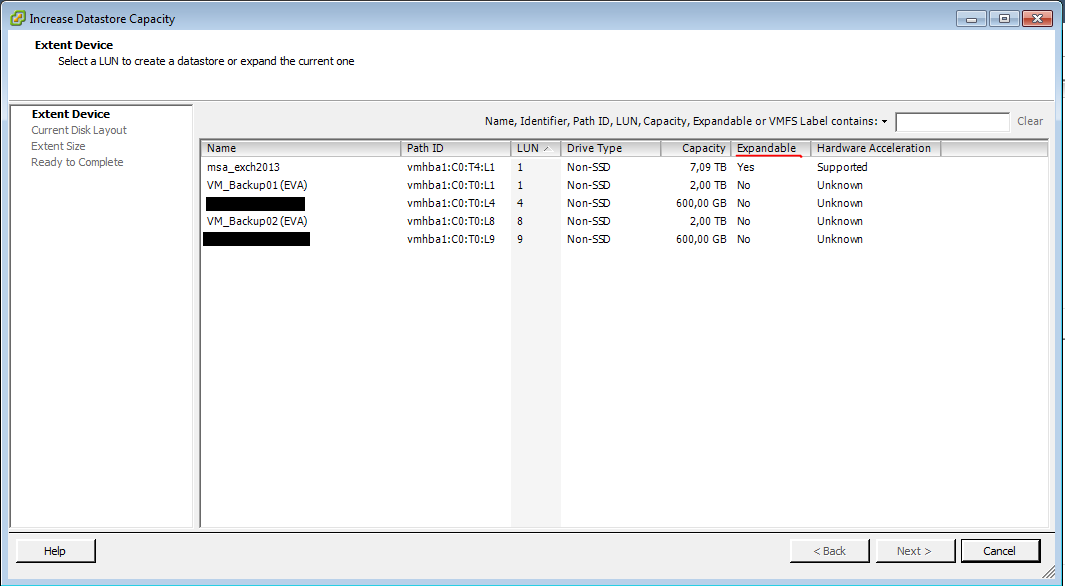

Поэтому пришлось искать в глубь и ширь. Поиск в базе знаний даёт подсказку When attempting to add an ESXi 5.x host to a DVS, the host is missing or the list is empty (2039046), но я мигрировал базу на vPostgres, поэтому необходимо понять как vPostgres готовить.

- Из файла C:\ProgramData\VMware\vCenterServer\cfg\vmware-vpx\vcdb.properties берем адрес и порт, которые слушает СУБД (localhost:5432), имя пользователя (vc) и копируем в буфер обмена пароль.

- Ставим PGAdmin и 32-битные библиотеки C++ Visual Studio 2013 Redistributable.

- Запускаем PGAdmin, вводим полученные ранее данные.

Раскрываем дерево — VCDB->Схемы->vc->Таблицы->VPX_DVS_COMPATIBLE, добавляем пару строк со значениями:

- повтор значения id(значение содержится в таблице VPX_DVS), esx, 6.0+;

- повтор значения id, embeddedEsx, 6.0+,

- жмём «Обновить» для автозаполнения последнего поля.

После этого подключаем хост в коммутатор. Если возникает ошибка, описанная в Adding an ESX/ESXi host to Nexus 1000v vDS fails with the error: vDS operation failed on host <hostname>, got (vmodl.fault.SystemError) exception (2007166), то на время подключения останавливаем службу VMware Update Manager (VIB модуль должен быть установлен вручную).

Если все вышесказанное не помогло, то делаем как написано ниже, но если вы не сделаете то, что выше, не факт, что сработает то, что ниже.

Как правильно обновлять хост ESXi 6.0 с Cisco Nexus 1000V

На данный момент официальная единственная возможность — это сразу вшивать VIB Cisco Nexus 1000V VEM в образ ESXi 6.0 и им обновляться.

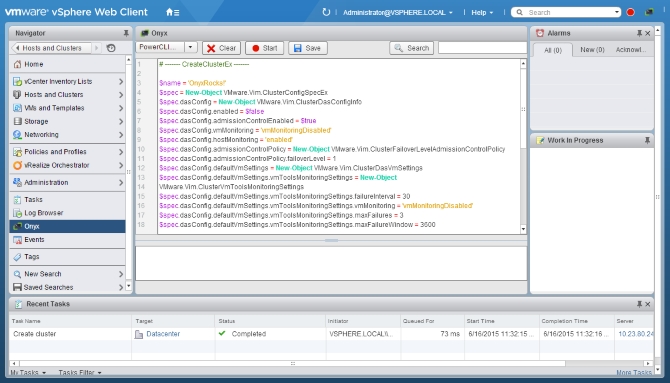

Все команды выполняются в PowerCLI:

PowerCLI C:\temp> Connect-VIServer vcenter

PowerCLI C:\temp> Add-EsxSoftwareDepot .\VMware-ESXi-6.0.0-2494585-depot.zip

Depot Url

---------

zip:C:\temp\VMware-ESXi-6.0.0-2494585-depot.zip?index.xml

PowerCLI C:\temp> Add-EsxSoftwareDepot .\VEM\VEM600-201504173119-BG-release.zip

Depot Url

---------

zip:C:\temp\VEM\VEM600-201504173119-BG-release.zip?index.xml

PowerCLI C:\temp> Get-EsxSoftwarePackage | where {$_.Vendor -eq "Cisco"}

Name Version Vendor Creation Date

---- ------- ------ ------------

cisco-vem-v173-esx 5.2.1.3.1.4.0-6.0.1 Cisco 16.04.201...

PowerCLI C:\temp> Get-EsxImageProfile | Select Name

Name

----

ESXi-6.0.0-2494585-no-tools

ESXi-6.0.0-2494585-standard

PowerCLI C:\temp> New-EsxImageProfile -CloneProfile ESXi-6.0.0-2494585-standard -Name ESXi-6.0-plus-VEM-6.0 -AcceptanceLevel PartnerSupported -Vendor "NotVmware"

Name Vendor Last Modified Acceptance Level

---- ------ ------------- ----------------

ESXi-6.0-plus-VEM-6.0 Cisco 06.02.2015 2... PartnerSupported

PowerCLI C:\temp> Add-EsxSoftwarePackage -ImageProfile ESXi-6.0-plus-VEM-6.0 -SoftwarePackage cisco-vem-v173-esx

Name Vendor Last Modified Acceptance Level

---- ------ ------------- ----------------

ESXi-6.0-plus-VEM-6.0 Cisco 08.06.2015 1... PartnerSupported

PowerCLI C:\temp> Export-EsxImageProfile -ImageProfile ESXi-6.0-plus-VEM-6.0 -ExportToISO -FilePath ESXi-6.0-plus-VEM-6.0.iso

За основу взята статья Upgrading an ESXi/ESX 4.x host with the Cisco Nexus 1000V to ESXi 5.x using Update Manager (2021363).

Вывод

Горе от ума вечно…